Il rapido sviluppo dell’intelligenza artificiale, e la molteplicità delle sue possibili applicazioni, hanno colto di sorpresa tanto gli addetti ai lavori, quanto il mercato degli utenti.

Per quanto fosse possibile prefigurarsi l’evoluzione e i campi di applicazione, in realtà, proprio grazie al suo fattivo impiego, per molti versi si è riusciti ad andare oltre le iniziali intenzioni.

Inizialmente testata in ambiente software/ludico, nei suoi primi impieghi ha trovato ingresso nell’automazione dei processi industriali, nell’istruzione di macchine e robot operativi, nell’impiego in ambiti applicativi ostili e pericolosi per la salute umana, nell’ambito sanitario per la realizzazione di strumenti diagnostici e di ausilio nell’esecuzione di procedure mediche, nella programmazione e nella sicurezza informatica, ed in molti altri campi applicativi compresi quello finanziario e quello militare.

Tuttavia, se inizialmente la tendenza era quella di affidare e delegare all’intelligenza artificiale tutte quelle operazioni che possiamo definire, con un termine ampio, meramente “esecutive”, ovvero di sostituzione dell’elemento umano per impieghi gravosi e ripetitivi, e per impieghi nei quali è richiesta la riduzione della marginalità di errori e la ossessiva osservanza delle procedure, successivamente tale tendenza è stata definitivamente ed ampiamente superata.

L’affidamento all’intelligenza artificiale di compiti di analisi e successiva scelta decisionale, stimando come valore assoluto l’analisi e la decisione fondata sulla valutazione matematica e statistica, ha aperto interi settori in cui originariamente era l’elemento umano a compiere scelte ed assumere decisioni.

Pensiamo ad esempio al settore delle analisi e delle previsioni finanziarie, allo sviluppo dei modelli climatici, ai modelli predittivi utilizzati tanto nell’automazione della mobilità quanto nella programmazione di carattere commerciale.

Si sta acquisendo consapevolezza, insomma, che l’intelligenza artificiale sta progressivamente prendendo campo non soltanto sulle attività umane di carattere esecutivo, ma anche sulle attività di carattere decisionale.

Intelligenze artificiali: distinzioni e pluralità

Il termine intelligenza artificiale costituisce una categoria generale che ne comprende diversi tipi.

Le tipologie di intelligenza artificiale sono classificate in base alla loro capacità di imitare le caratteristiche umane. Abitualmente si distinguono tre tipi di intelligenza artificiale: ANI (Artificial Narrow Intelligence); AGI (Artificial General Intelligence) e ASI (Artificial Super Intelligence).

Ognuna di queste tipologie ha le sue specifiche e le sue caratterizzazioni.

L’ ANI (Artificial Narrow Intelligence) o intelligenza artificiale ristretta, è una tipologia che viene impiegata in attività limitate per compiti ristretti. Questa tipologia di IA non ha la capacità di comprendere o svolgere attività al di fuori del suo ambito operativo.

Le ANI sono utilizzate in una grande varietà di applicazioni, come ad esempio gli assistenti vocali che siamo abituati a consultare (Siri, Alexa, Cortana ecc.), sistemi di riconoscimento di immagini ed identificazione delle persone, motori di ricerca, motori di raccomandazione, sistemi di guida dei veicoli.

I limiti delle ANI sono quelli di non avere la capacità di sviluppare competenze diverse da quelle per cui sono state progettate.

AGI (Artificial General Intelligence) o intelligenza artificiale forte, è una tipologia di intelligenza che ha la capacità di apprendere e capire, ed adottare decisioni similmente a quello che fa un essere umano.

Il campo della ricerca e della sperimentazione nell’intelligenza artificiale forte si è trovato davanti al difficilissimo compito di replicare la complessità della mente umana. E proprio a proposito di questo tipo di ricerca, è stato messo in discussione il valore dell’intelligenza artificiale. Il limite del processamento dei dati si basa sul fatto che la macchina lavora su dati codificati, ma non ha attualmente capacità di apprendimento al di fuori degli algoritmi di funzionamento che le permettono di processare i dati codificati.

Non c’è di fatto una reale comprensione delle informazioni e dei dati nella loro essenza e al di fuori degli algoritmi di funzionamento. Questa “incapacità” intrinseca costituisce ancora un insuperabile abisso tra la mente umana e la IA, per quanto diversi enti stiano lavorando a progetti di sviluppo al riguardo.

L’ASI (Artificial Super Intelligence) è un tipo di IA superiore alle capacità umane. Si tratta per ora di un concetto puramente teorico, certamente un obiettivo futuro, per lo sviluppo di capacità cognitive superiori a quelle umane in tutti i campi di applicazione, incluse le capacità creative ed espressive. Anche se il concetto appare futuristico, tuttavia occorre prendere atto che già oggi l’impiego dell’IA ha impresso una decisa accelerazione ai progressi tecnologici sia nel settore hardware e software, sia nello sviluppo di nuovi modelli applicativi. Pertanto i tempi ritenuti appartenere ad un lontano futuro, potrebbero in realtà essere più vicini di quanto si pensi ed avvicinarsi progressivamente sempre di più.

In aggiunta alle summenzionate distinzioni, occorre evidenziare che la corsa scientifica e tecnologica all’avanzamento della IA, soltanto parzialmente è condotta su piattaforme condivise ed alla luce del sole. In concreto la ricerca sulla IA si affianca alla ricerca della supremazia tecnologica, industriale e commerciale, e sulla ricerca di brevetti che garantiscano la leadership del settore.

In tale contesto non è possibile parlare di IA come riferimento ad un unico modello di intelligenza artificiale, ma appare più corretto fare riferimento a diversi modelli di sviluppo di IA sui quali lavorano numerosi gruppi di ricerca, e in molti casi diverse potenze economiche ed industriali.

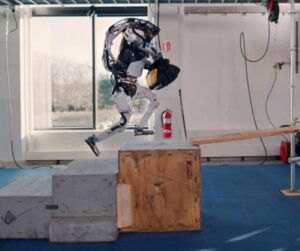

In tempi recenti, alcune dimostrazioni pubbliche, come quelle diffuse dalla Boston Dynamics sulla operatività dei propri robot, hanno destato una certa impressione per le capacità dimostrate in equilibrio, versatilità applicativa e capacità motoria. Robot capaci di ballare, di correre, di saltare, di muoversi in ambienti difficili, di eseguire operazioni con carichi di lavoro impensabili per un essere umano.

Tutto ciò ha prodotto una grande esaltazione, ma allo stesso tempo anche una grande inquietudine dettata dal fatto che, tutto sommato, un prodotto della mente e dell’ingegno umano sia riuscito in definitiva a pareggiare molte delle capacità umane e, in diversi settori, a superarle.

L’intelligenza artificiale come mezzo per la supremazia tecnologica e militare.

Quello che generalmente, e soprattutto odiernamente, spinge in avanti la ricerca scientifica e tecnologica è un enorme flusso finanziario: dietro ogni ricerca dei tempi moderni (a parte rarissime e confinate eccezioni che potremmo definire artigianali) si palesano grandi interessi economici, spesso mascherati con intenti filantropici o pseudo scientifici, che chiedono alla fine del progetto e dello sviluppo il rientro dell’investimento effettuato.

Tra i settori più interessati alla ricerca e lo sviluppo della IA primeggia sicuramente quello militare. Già alla fine degli anni ‘90 lo sviluppo delle armi aveva dotato missili, aerei, sottomarini e satelliti di spionaggio con sistemi di guida e di intercettazione intelligenti, in grado di individuare e puntare gli obiettivi con grande efficienza e precisione.

Lo sviluppo della tecnologia militare è finalizzato a realizzare analisi ed individuazione degli obiettivi, miglioramento dei processi decisionali, ottimizzazione della logistica e del dislocamento personale e mezzi, ottimizzazione e sicurezza delle reti di comunicazione, ausilio per la selezione del personale.

Anche nell’ambito dell’addestramento militare si è manifestato un massiccio utilizzo della IA per strutturazione del training, realizzazione degli scenari, realizzazione modelli di simulazione e predittivi, simulazione bellica.

Con l’impiego sempre più esteso dei droni, e dei sistemi difensivi dotati di sensori intelligenti, si è definitivamente presa una direzione ben precisa per lo sviluppo delle capacità militari con l’utilizzo della IA.

La tendenza che da tempo si è manifestata è, infatti, quella di sostituire nelle operazioni militari le macchine intelligenti al personale sul campo, così da limitare i danni ed i costi in termini di vite umane. Tuttavia questo tipo di approccio in realtà limita i rischi soltanto per il personale umano di chi è in grado di impiegare queste tecnologie.

In questo delicatissimo settore, spesso si è parlato di armi “intelligenti” in grado di colpire gli obiettivi con precisione chirurgica, limitando gli effetti collaterali in termini di vite umane, soprattutto in riferimento alle vittime civili.

In realtà, proprio i recenti scenari di guerra che si sono aperti nel mondo, ci restituiscono una situazione del tutto diversa.

L’umanità è uscita da due conflitti mondiali, con il chiarissimo quadro della disumanità agghiacciante della guerra e degli effetti da essa provocati. Il futuro che si affaccia, però, non è quello di rendere le guerre e/o i conflitti meno disumani rispetto a quello che si è vissuto in precedenza.

La sostituzione di mezzi e personale militare con mezzi intelligenti e robot da combattimento, consegna mezzi e strumenti nelle mani, o meglio nei circuiti, di decisioni assunte sulla base del mero calcolo, e dell’efficienza matematica e statistica.

La disumanizzazione della guerra segue da vicino la disumanizzazione delle fabbriche, la disumanizzazione degli istituti finanziari, degli esercizi commerciali, delle aule di insegnamento didattico, della prestazione di cura ed assistenza, della gestione delle emergenze.

L’uomo sta delegando alle macchine diverse parti della propria rete relazionale e decisionale.

Finché l’impiego della IA è stato limitato all’esecuzione di compiti gravosi e ripetitivi nell’ambito produttivo, sotto l’assoluto controllo decisionale umano, tale impiego risultava essere di assoluto beneficio alla società umana.

Ora, vista la direzione di sviluppo della IA, è giusto chiedersi quali siano i rischi derivanti dall’affidare alla IA oltre a compiti meramente operativi, anche compiti valutativi e decisionali in sostituzione dell’elemento umano.

Questa sembra essere la breccia attraverso la quale introdurre un processo di disumanizzazione del contesto sociale.

Informazione e disinformazione

L’intelligenza artificiale attualmente domina il mondo dei flussi di informazione e della rete internet.

Uno dei grandi problemi dell’era moderna è costituito dalla gestione e diffusione delle informazioni, dalla verifica delle informazioni circolanti alla scelta delle informazioni da diffondere.

L’informazione nell’era moderna è l’elemento costitutivo, il mattone di costruzione, delle analisi per operare scelte politiche, economiche, finanziarie e sociali.

Avere accesso e dominio sull’informazione significa poter interferire sui risultati di analisi e previsioni e, conseguentemente, orientare le decisioni da prendere praticamente in ogni settore.

La disinformazione e la “misinformazione” (definita così l’informazione non volutamente errata) costituiscono attualmente il primo rischio a livello mondiale a breve termine (entro due anni).

Estremamente delicato è, quindi, capire nelle mani di chi o di cosa è riposto il controllo dell’informazione e la sua diffusione a livello planetario.

Questo ci dice il rapporto “Global Risk Report 2024” del WEF (World Economic Forum).

Il rapporto in questione, specifica che nei prossimi due anni gli attori stranieri e nazionali faranno leva sulla disinformazione e sulla misinformazione per ampliare le divisioni sociali e politiche.

I rischi della disinformazione rivolta alla popolazione attengono al condizionamento delle elezioni politiche che si terranno nei vari Paesi del mondo nei prossimi due anni. Di questi giorni sono le elezioni in Russia, che subiscono le spinte di informazioni contrastanti da fonti interne e da fonti estere, e la campagna politica per le presidenziali degli Stati Uniti d’America. Le persone coinvolte nella scelta politica dei prossimi due anni corrispondono a quasi la metà della popolazione del pianeta.

La disinformazione, inoltre, è in grado di innescare processi di rivolte sociali e disordini civili, per disinnescare i quali i governi dovrebbero adottare politiche di prevenzione e di repressione.

Questo, in parole povere, significa che sono a rischio i sistemi governativi mondiali.

Secondo gli esperti di NewsGuard, centro di monitoraggio della disinformazione e della misinformazione, finora sono stati identificati 750 siti di notizie e informazioni generate dall’Intelligenza Artificiale che operano con poca o nessuna supervisione umana. E’ stato rilevato che l’intelligenza artificiale generativa ha realizzato questi siti in 15 lingue, quali: ceco, olandese, indonesiano, tagalog, arabo, cinese, francese, inglese, italiano, coreano, portoghese, spagnolo, tedesco, thailandese, turco.

Questi siti producono centinaia di articoli su vari argomenti, tra cui anche politica e tecnologia, e riferiscono di eventi palesemente inventati o ripresi da fatti passati. I siti in questione vengono realizzati per guadagnare sulla pubblicità visualizzata, e creano così un ulteriore incentivo alla loro diffusione su vasta scala, e in alcuni casi per manipolare l’orientamento di intere popolazioni.

Tra i siti identificati ne è stato trovato uno gestito dal governo cinese che cita informazioni generate dall’IA come fonte affidabile, per sostenere la falsa teoria secondo cui gli Stati Uniti gestiscono un laboratorio di armi biologiche in Kazakistan. Secondo tale teoria, nel laboratorio verrebbero infettati dei cammelli per danneggiare la popolazione cinese.

Dal tenore e dal tipo di disinformazione rilevata si possono comprendere i rischi che corrono gli Stati ed i popoli causati dalla diffusione di false notizie.

Immaginiamo solo per ipotesi la diffusione di false notizie economico o finanziarie come possono spostare a livello globale gli assetti economici, il trasferimento delle ricchezze e l’impatto con la produttività dei singoli paesi.

La guerra per il controllo della IA

A valle di tutte le analisi e le considerazioni che abbiamo svolto il reale problema che si pone nell’immediato è quello di capire chi controlla la IA e quali sono gli accorgimenti e gli strumenti per ottenere tale controllo.

Non esistendo un’intelligenza artificiale centralizzata, ma sussistendo diverse intelligenze artificiali ciascuna controllata da un diverso ente, le stesse si pongono anche in posizione confliggente tra di loro.

Nell’esempio della disinformazione se esiste una IA per creare disinformazione ne esiste anche una per analizzare i flussi di informazione e rilevare la disinformazione creata dalla stessa o altra IA.

Sorgono quindi anche meccanismi di conflittualità tra le diverse intelligenze artificiali e nella corsa al dominio politico, economico e commerciale globale la prossima frontiera è costituita dalla realizzazione di un’intelligenza artificiale in grado di prevalere sulle altre e di anticipare possibilmente le loro mosse.

Attualmente non esiste un’autorità a livello globale che abbia potere decisionale e coercitivo per imporre una specifica politica o delle regole di disciplina dell’intelligenza artificiale.

Nell’ambito dell’Unione Europea il Parlamento ha approvato in data 13 marzo 2024 la legge sull’intelligenza artificiale che stabilisce nelle proprie norme le applicazioni vietate all’IA tra le quali i sistemi di categorizzazione biometrica basati su caratteristiche sensibili, l’estrapolazione di immagini facciali da internet, la creazione di banche dati di riconoscimento facciale tramite acquisizione dei sistemi delle camere a circuito chiuso e sistemi che manipolano il comportamento umano.

Sono formulate eccezioni per le forze dell’ordine relative ai sistemi di identificazione biometrica mentre sono previsti anche specifici obblighi per l’impiego dell’IA in sistemi ad alto rischio, ovvero sistemi legati alla salute dei cittadini, alla sicurezza, ai diritti fondamentali, all’ambiente, alla democrazia e allo stato di diritto.

Tuttavia questo tipo di normativa appare essere esclusivamente una normativa di indirizzo e di contenimento ma non pone in alcun modo al riparo la società dal rischio di cattivo utilizzo dell’IA.

Come avevamo accennato la ricerca e lo sviluppo, soprattutto nell’ambito militare e governativo tendono alla ricerca e alla creazione di una super IA in grado di poter attuare la prevalenza di un determinato gruppo o contesto su tutti gli altri e garantire così quella che per anni è stato campo di battaglia delle varie corporate sparse per il mondo, ovvero quello della supremazia tecnologica.

L’interrogativo è su quale sia il prezzo per raggiungere tale supremazia, e quindi quale il costo effettivo che l’umanità dovrà pagare per conseguirlo.

Per capire in concreto quali sono le problematiche, ci basti riflettere sulla circostanza che si partiva all’inizio del secolo scorso dalle leggi della robotica di Asimov, che teorizzavano l’integrità dell’essere umano come valore assoluto da rispettare da parte delle macchine, mentre oggi ci troviamo di fronte alla possibile costruzione di eserciti militari dotati di robot combattenti che non rispondo a questa regola, e hanno la semplice funzione di eliminare i loro obiettivi sia pure costituiti da esseri umani.

Superato questo limite, sappiamo per certo ora che l’essere umano per il momento, con difficoltà, e sempre in modo conflittuale mantiene la leadership decisionale e operativa in molti settori delle attività umane; ma non sarà uno scenario improbabile quello che vedrà trasferire il comando delle operazioni in capo a qualcosa che conosciamo ancora poco, e di cui sappiamo ancora meno circa le possibilità di sviluppo operativo.

Possiamo però affermare che la prossima guerra futura dell’umanità sarà per l’affermazione delle capacità e delle potenzialità dell’intelligenza artificiale dei singoli Stati, e che dall’esito di questa battaglia dipenderà il futuro della intera specie umana.

Conclusioni

La corsa dell’uomo è sempre orientata a conseguire traguardi futuri.

Tuttavia fermandoci un momento e gettando uno sguardo al passato non può non destare inquietudine riflettere sul fatto che negli anni ‘80 sono stati introdotti i personal computer, e a ridosso degli anni ‘90 sono stati introdotti i primi telefoni mobili; parliamo di ieri e dell’altro ieri.

Ci stiamo rendendo conto proprio in questo periodo che la corsa tecnologica sta superando le nostre capacità di adattamento e di adeguamento al contesto e che, per quanto capaci e intelligenti, essendo legati ai tempi dei ritmi biologici e naturali, non riusciamo a tenere il passo dell’evoluzione elettronica e cibernetica e neppure quella dell’autoapprendimento delle macchine che abbiamo creato.

Più che regolamentare o arginare gli effetti dell’intelligenza artificiale, gli studi necessari a traghettare l’uomo in un nuovo contesto dovrebbero essere orientati da un lato a dispensare centellinando le innovazioni tecnologiche per concedere il necessario tempo di apprendimento e assimilazione che è necessario all’uomo e che non corrisponde certamente a quello che manifesta la macchina, da un altro lato a creare un processo di garanzia assoluta nei confronti dell’intelligenza artificiale che a capo in cima alla stessa ci sia sempre un ente, un’organizzazione o un comitato possibilmente di carattere internazionale e condiviso in grado di poter disattivare o spegnere i processi attivati in qualsiasi momento.

Le care vecchie chiavi dell’automobile, che venivano utilizzate per aprire il veicolo e per accendere il quadro strumenti e il motore e che davano la certezza del controllo sul funzionamento del veicolo, e che invece adesso sono state sostituite da sensori intelligenti che un giorno potrebbero non rispondere ai comandi.